讲座回顾 | 洪永淼:数智时代计量经济学与统计学研究范式的演变 发布时间:2024-03-04

2024年3月1日上午,《数智时代计量经济学与统计学研究范式的演变》主题讲座在交大安泰经管学院A409教室顺利举办。

中国科学院数学与系统科学研究院关肇直首席研究员、中国科学院预测科学研究中心主任、中国科学院大学经济与管理学院院长,发展中国家科学院院士洪永淼教授做主题演讲。安泰经管学院副院长朱喜致辞并主持活动,校务委员会专职副主任顾锋致辞并做总结。活动吸引了近百名安泰经管学院的教师及博士生积极参与,共同探讨计量经济学与统计学在数智时代的最新发展。

朱喜副院长在开场致辞中,对各位嘉宾和师生的到来表示热烈的欢迎,并简要介绍了本次讲座的主题和目的。他强调,在数字化、智能化的时代背景下,计量经济学与统计学的研究范式正经历着深刻的变革,希望通过此次讲座,能够为大家提供一个交流学习的平台,共同推动相关学科的发展。

洪永淼教授深入浅出地阐述了数智时代计量经济学与统计学的最新研究范式和变革趋势。展示了大数据和人工智能如何重塑传统学科的研究方法和应用领域,为在座师生带来了一场思想的盛宴。讲座过程中,与会教师与洪教授进行了热烈的互动与交流,共同探讨数智时代学术研究的挑战与机遇。

活动最后,顾锋教授对活动进行了总结。他高度评价了本次讲座的学术水平和交流效果,认为这不仅是一次知识的分享,更是一次思想的碰撞和灵感的激发。他强调,大数据时代的到来,为我们带来了研究范式、研究方法以及研究平台的深刻变革,这是一个不容忽视的时代趋势。我们必须积极拥抱数智时代,主动适应并利用智能模型等先进工具,不断更新我们的研究方法和手段,以应对数智时代带来的挑战。

以下是演讲精华内容整理稿,与您分享。

洪永淼 教授

中国科学院数学与系统科学研究院关肇直首席研究员

中国科学院预测科学研究中心主任

中国科学院大学经济与管理学院院长,发展中国家科学院院士

研究领域为计量经济学、时间序列分析、金融计量学、统计学、中国经济,在 Annals of Statistics、Biometrika、Econometrica、Journal of American Statistical Association、Journal of Political Economy、Journal of Royal Statistical Society B、Quarterly Journal of Economics、Review of Economic Studies、Review of Financial Studies、《经济研究》《管理世界》等经济学、金融学和统计学中英文主流期刊以及China Daily、《人民日报》《光明日报》《经济日报》等主流报纸发表文章 150 余篇。出版《概率论与统计学》《高级计量经济学》、Probability and Statistics for Economists、Foundations of Modern Econometrics: A Unified Approach 等中英文著作。2014-2022 年连续 9 年入选 Elsevier经济学/统计学中国高被引学者榜单。

01

数智时代冲击传统范式

随着人工智能科技的飞速发展,大数据的4Vs特征(容量大、变量多、强关联、噪声大)切实对社会科学研究范式带来巨大冲击。

人工智能概念起源于上个世纪 50 年代,其目标功能与统计学中非参数统计的基本思想类似,但直到过去 20 年,在算力算法发展壮大的基础上,人工智能才于实际应用中实现飞速突破,衍生出人类颠覆性发明,如机器学习、深度学习、ChatGPT、Sora等。

诺贝尔经济学奖获得者Joshua Angrist:“任何希望从数据中得到有用推断的人都可称为应用计量经济学家。”(Angrist and Pischke, 2009)

02

大数据与统计测量

统计测度是统计科学的基础,也是所有使用统计方法进行推断的实证研究的基础。

从定性到定量,从单领域到跨学科,通过使用高频数据来预测低频变量、通过使用文本数据突破样本代表性等传统障碍……海量微观大数据正在大大改进和提升经济测度。

03

宏观统计与微观统计的交叉融合

步骤2:对宏观统计变量及其关系进行建模

步骤3:基于宏观统计模型进行推断与预测

04

基于大模型的统计建模方式

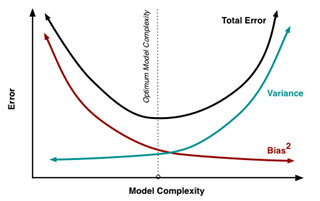

计量经济最早的模型是线性回归模型,后来随着情况逐渐复杂,演变出非线性回归模型,后续相继出现非参数模型、机器学习、深度学习、ChatGPT、Sora……可以发现,模型范式的演变,是一个模型复杂度、模型未知参数个数从小到大演进的过程。

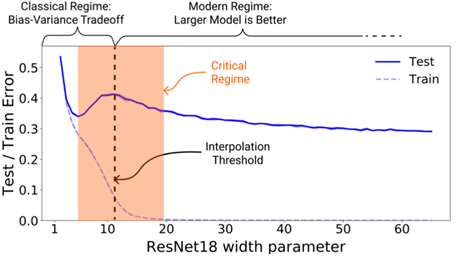

“双降现象”是指在U型特征基础上,一旦让模型的复杂度一直增加,均方误差会出现第二次下降。这是大模型领域发展带来的重大发现。

很长一段时间里,统计学家和计量经济学家一直聚焦于“小模型”空间。大数据的出现,让学者们发现存在一个以前不知道的“大模型”空间,那里的大模型特征与能力显著不同于小模型,如存在所谓“涌现”现象。

然而,维数灾难(Curse of Dimensionality)一直是统计学与计量经济学面临的一个根本问题。当建模包含的因素特别多,每个因素的影响可能都很微小,扔掉一个因素可能影响不大,但是如果扔掉很多这种微小影响变量,则产生结果就可能是不可忽略的。对此,实现降维(Dimension Reduction)便是统计学家、计量经济学家应对维数灾难的解决方法。

传统的一个重要降维思路是数据缩减(Data Reduction),即先对高维复杂数据进行降维,这不仅需要很强的假设(如正态分布),还会造成数据信息损失,例如数据加总(Aggregation)、PCA、充分统计量(Sufficient Statistic)。第二种降维思想是模型简化(Model Reduction),先利用大模型对高维复杂数据进行建模,再进行降维,例如Additive Regression Model、Single Index Model。当模型复杂度足够高,可以利用统计的检验方法和经济理论约束条件(如宏观经济学的欧拉方程、动态资产资本定价模型一阶条件),把该高维模型投影到一个低维的函数空间。其好处为一些数据的有用信息不会在一开始就被主观剔除掉。

例如,在大模型与精准统计预测中,一个模型的预测能力取决于模型的“信噪比”(Signal To Noise Ratio)。对于预测模型Y_(t+h)=g(X_t)+ε(t+h),其中X_t是可观测预测变量集, g(X_t)是预测模型,ε_(t+h)是噪声。

大数据极大拓展了可观测变量集 X_t,因此大幅度提升预测模型的信噪比。要妥善处理高维或超高维信息集 X_t,以及可能的非线性关系,同时避免维数灾难,可以使用机器学习以及其他大模型。

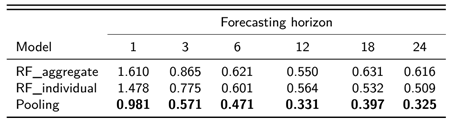

大数据+大模型有可能会显著提升预测精准度。例如,Hong, Huang, Wang & Zhao (2023)基于1500家上市公司的股市价格,对通货膨胀率进行预测,发现与基于宏观经济金融数据的预测相比,大数据+大模型预测要精准得多。

05

因果推断和可解释统计学

当下,一方面,人工智能可以帮忙改善对反事实(Counterfactuals)的估测,从而改进基于观测数据的因果推断。但另一方面,AI,特别是那些大模型,就像个“黑箱”,随着AI和大模型越来越广泛地应用,我们就更需要发展可解释统计学(Interpretable Statistics)了。在这方面,计量经济学做得不错,因为它强调的是统计学方法和经济理论的完美结合。目前,可解释统计学还在非常初步的阶段,但这是统计科学未来非常重要的发展方向之一。

文:高静 张文珺

编辑:高静

审稿:薛静 康聪娟